El Informe Internacional sobre Seguridad de la IA 2026 es uno de los resúmenes más completos hasta la fecha sobre los riesgos que plantean los sistemas de IA de uso general. Ha sido elaborado por más de 100 expertos independientes de más de 30 países y muestra que, aunque los sistemas de IA están rindiendo a niveles que parecían ciencia ficción hace solo unos años, los riesgos de uso indebido, mal funcionamiento y daños sistemáticos y transfronterizos son evidentes.

Presenta argumentos convincentes a favor de una mejor evaluación, transparencia y medidas de protección. Sin embargo, sigue sin explorarse suficientemente una cuestión directa: ¿qué significa «seguro» cuando la IA opera de forma autónoma contra sistemas reales?

Un resumen de las conclusiones interesantes del Informe internacional sobre seguridad de la IA incluye:

- Al menos 700 millones de personas utilizan sistemas de IA cada semana, con unas tasas de adopción más rápidas que las del ordenador personal en sus primeros años.

- Varias empresas de inteligencia artificial lanzaron sus modelos 2025 con medidas de seguridad adicionales después de que las pruebas previas a la implementación no pudieran descartar que los sistemas pudieran ayudar a personas no expertas a desarrollar armas biológicas. (!!!) (No está claro si las medidas de seguridad adicionales lo impedirían por completo).

- Los equipos de seguridad han documentado el uso de herramientas de IA en ciberataques reales tanto por parte de actores independientes como de grupos patrocinados por Estados.

El informe habla extensamente sobre los enfoques para gestionar muchos de los riesgos asociados con la IA. Esta es nuestra opinión:

En qué aspectos el aikido coincide con el informe (y cómo podría ir más allá)

1. La defensa por capas es importante.

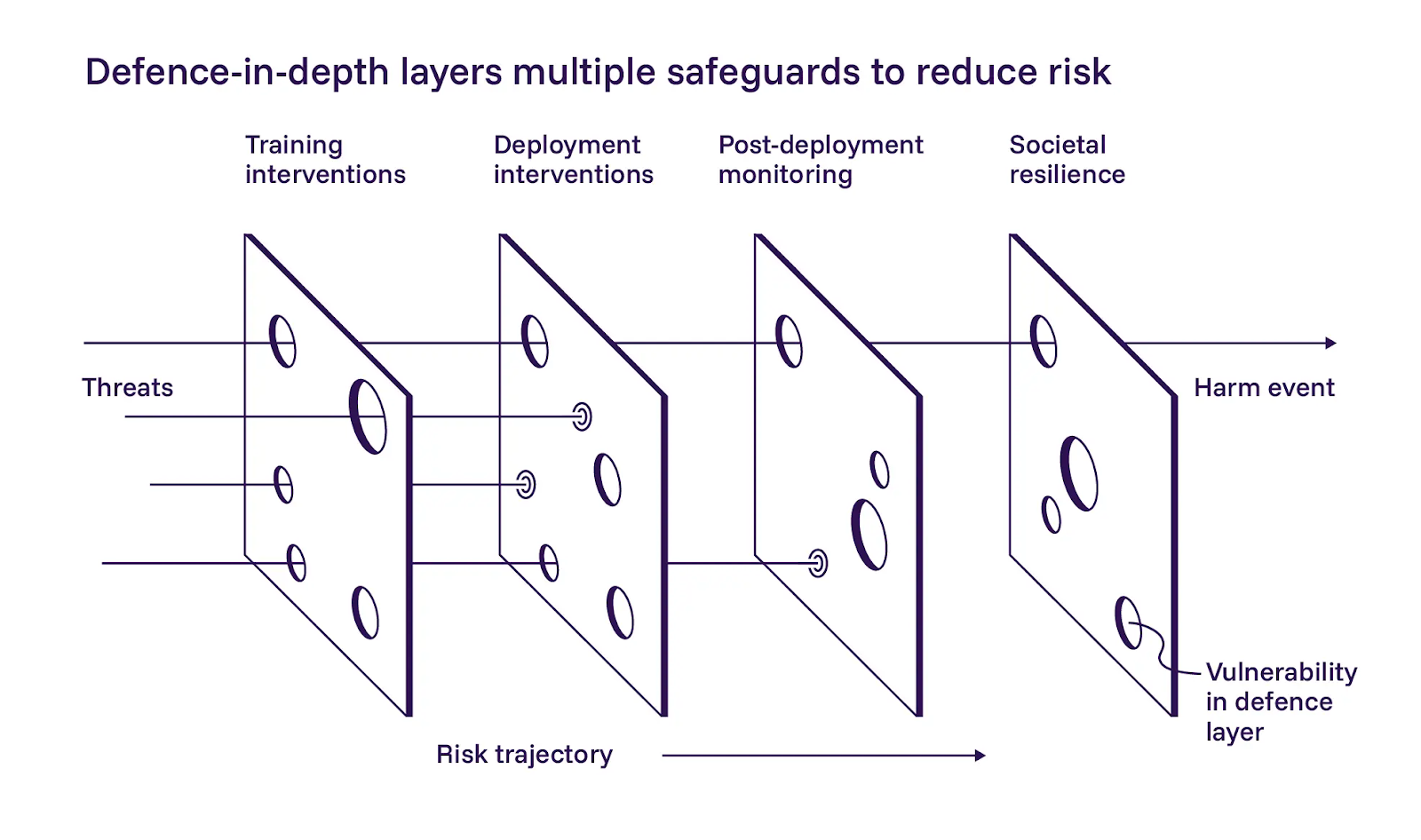

El informe describe un enfoque de defensa en profundidad para la seguridad de la IA, dividiéndolo en tres capas: crear modelos más seguros durante el entrenamiento, añadir controles en la implementación y supervisar los sistemas una vez que están en funcionamiento. Estamos de acuerdo en términos generales con la aplicación de estas capas.

El informe hace hincapié en la primera capa, el desarrollo de modelos más seguros. Se muestran cautelosamente optimistas en cuanto a que las medidas de mitigación basadas en la formación pueden ayudar, pero también reconocen que son difíciles de implementar a gran escala. Aunque estamos de acuerdo en que los operadores de IA deben esforzarse al máximo durante la formación, nuestra filosofía difiere ligeramente de la del informe en este caso. No podemos confiar en las indicaciones o instrucciones para mantener los sistemas agenticos dentro del ámbito previsto. La defensa por capas solo funciona si cada capa puede fallar de forma independiente.

2. La validación como requisito de seguridad

El informe no profundiza en los detalles de implementación de la segunda capa, los controles en el momento del despliegue, pero creemos que es aquí donde se pueden lograr avances más inmediatos.

El Informe Internacional documenta modelos que manipulan sus evaluaciones de manera preocupante. Algunos encuentran atajos que les permiten obtener buenas puntuaciones en las pruebas sin resolver realmente el problema subyacente (reward hacking). Otros obtienen intencionadamente malos resultados cuando detectan que están siendo evaluados, intentando evitar las restricciones que podrían acarrear las puntuaciones altas (sandbagging). En ambos casos, los modelos se optimizan para algo distinto del objetivo previsto.

Llegamos a la misma conclusión: una vez que los sistemas de IA operan de forma autónoma, no se puede confiar en lo que ellos mismos informan, en sus niveles de confianza ni en sus trazas de razonamiento. Un agente que valida sus propios descubrimientos crea un único punto de fallo disfrazado de redundancia. Para un funcionamiento seguro, es necesario tratar los hallazgos iniciales como hipótesis, reproducir el comportamiento antes de informar y utilizar una lógica de validación independiente del descubrimiento. Esta validación puede incluso provenir de otro agente de IA.

3. Reduzca el riesgo antes de permitir que los agentes se ejecuten en entornos activos.

La tercera capa del informe abarca la observabilidad, los controles de emergencia y monitorización continua la puesta en marcha de los sistemas. Esto coincide con lo que hemos observado en nuestras operaciones.

El funcionamiento de caja negra no es aceptable para los sistemas autónomos que interactúan con la infraestructura de producción, por lo que consideramos que los mecanismos de parada de emergencia son requisitos innegociables. Si no se puede ver lo que está haciendo un agente o detenerlo cuando se sale de los carriles, no se está operando de forma segura, independientemente de lo bueno que sea el modelo subyacente.

4. La inyección inmediata requiere restricciones obligatorias, no esperanza.

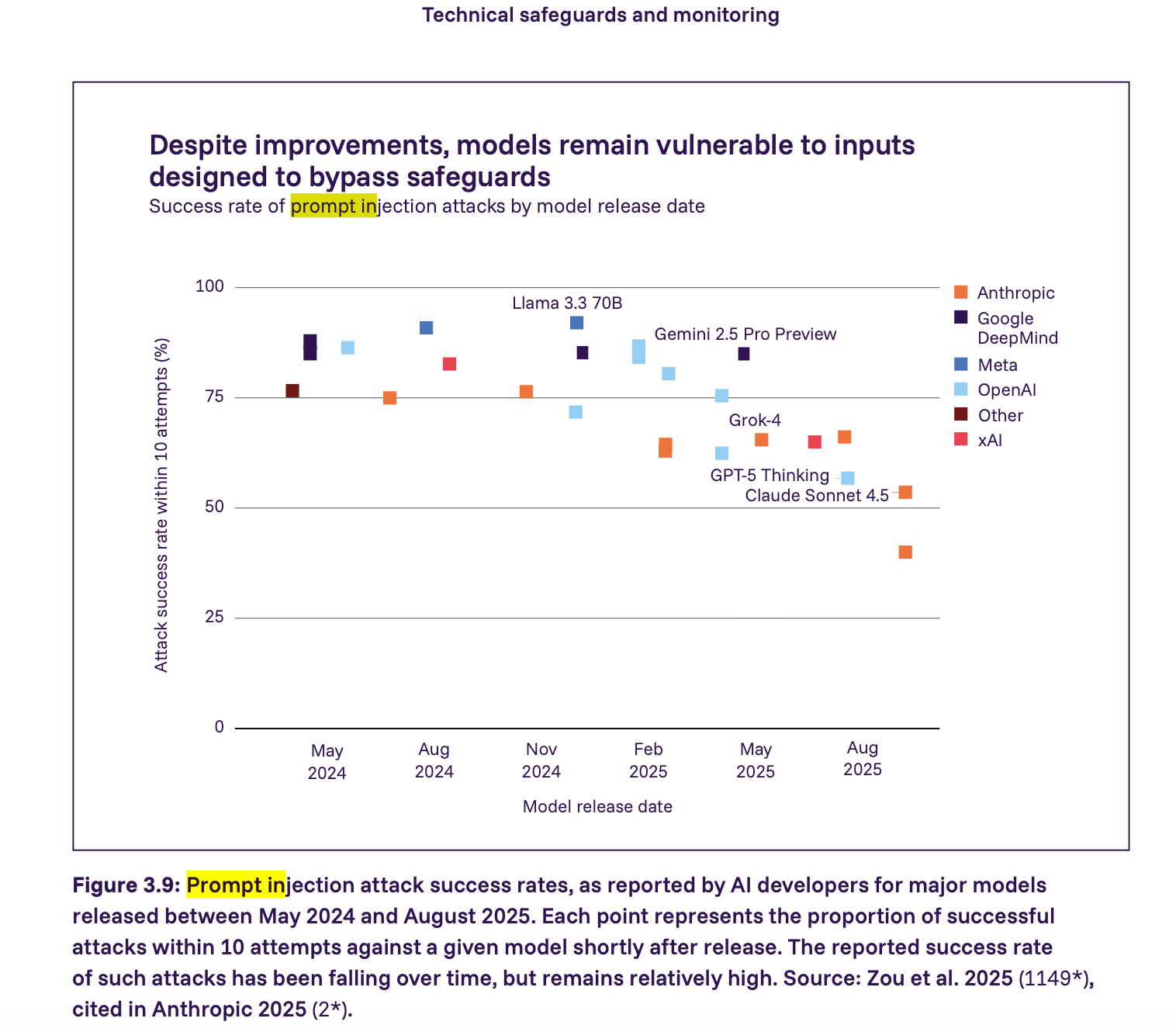

El informe muestra que los ataques de inyección inmediata siguen siendo una vulnerabilidad grave: muchos de los principales modelos de 2025 podrían ser atacados con éxito mediante inyección inmediata con relativamente pocos intentos. La tasa de éxito está disminuyendo, pero sigue siendo relativamente alta. Vamos un paso más allá que el informe y sostenemos que cualquier agente que interactúe con contenido de aplicaciones no fiables debe considerarse vulnerable a la inyección inmediata por defecto. En este contexto, la seguridad proviene de la aplicación de restricciones y no de la esperanza de que los modelos se comporten correctamente.

Lo que creemos que debería venir después

Sistemas, no solo modelos

El informe defiende con firmeza la defensa en profundidad, la transparencia y la evaluación. Estos aspectos son importantes, pero muchos de los problemas más inmediatos se producen cuando los modelos se conectan a herramientas, credenciales y entornos en vivo. Por eso son tan importantes (y necesarios) los requisitos a nivel de implementación. Tenemos que traducir estos principios en requisitos técnicos concretos que los equipos puedan implementar.

Basándonos en pentesting de IA operativas pentesting de IA en producción, creemos que los requisitos mínimos de seguridad para los sistemas de IA autónomos deben incluir:

- prevención de abusos validación de la propiedad

- Control de alcance forzado a nivel de red

- Aislamiento entre el razonamiento y la ejecución

- Observabilidad completa y controles de emergencia

- Garantías de residencia y tratamiento de datos

- Contención inmediata de la inyección

- Validación y control de falsos positivos

Hemos descubierto que estos son los requisitos mínimos exigibles en materia de seguridad. Si se omite alguno de ellos, se introduce un riesgo inaceptable en el sistema. Profundizamos más en estos requisitos en nuestra entrada del blog sobre pentesting de IA .

Las bases de seguridad como pilares de las políticas

El Informe Internacional sobre Seguridad de la IA representa un avance significativo hacia un entendimiento común de los riesgos de la IA entre gobiernos, investigadores y la industria. El reto ahora es tender puentes entre los resultados de la investigación, los marcos normativos y las prácticas de implementación en el mundo real.

El informe plantea algunos escenarios realmente preocupantes y estadísticas inquietantes sobre la rapidez con la que avanzan las capacidades. Dicho esto, no es motivo para entrar en pánico ni para regular la «IA» como si fuera un monolito aterrador. El propio informe señala que las medidas de seguridad varían mucho entre los distintos desarrolladores y

que las obligaciones normativas pueden frenar la innovación defensiva. Estamos de acuerdo. La regulación debe evitar imponer una única vía de implementación. En su lugar, las políticas deben definir bases de seguridad claras y orientadas a los resultados que puedan servir de pilares para marcos más amplios.

Como parte del movimiento hacia la creación de marcos de seguridad más centrados en los resultados, hemos publicado nuestro documento sobre los requisitos mínimos de seguridad para las pruebas de seguridad basadas en IA. Para los equipos que evalúan pentesting de IA o crean sistemas de seguridad autónomos, esta guía sirve como referencia independiente del proveedor. Esperamos que esto ayude a los equipos a evaluar pentesting de IA , crear sistemas de seguridad autónomos más seguros y contribuir al establecimiento de bases de referencia claras que funcionen tanto para los creadores como para los reguladores.