El auge de la IA en la ciberseguridad es imposible de ignorar. Los modelos de lenguaje grandes (LLM), como GPT-4, han cobrado protagonismo y están presentes en todo, desde asistentes de código hasta herramientas de seguridad. Las pruebas de penetración, que tradicionalmente eran un proceso lento y manual, están experimentando ahora una revolución impulsada por la IA. De hecho, en un estudio reciente, 9 de cada 10 profesionales de la seguridad afirmaron que creen que la IA acabará sustituyendo a las pruebas de penetración. La promesa es tentadora: imagina la minuciosidad de un pentester experimentado combinada con la velocidad y la escala de una máquina. Aquí es donde entra en juego el concepto de «Pentest GPT», que está cambiando nuestra forma de pensar sobre la seguridad ofensiva.

Pero, ¿qué es exactamente Pentest GPT? Y, lo que es igual de importante, ¿qué no es? Antes de que te imagines un script ChatGPT glorificado que hackea sistemas por arte de magia, aclaremos el término y exploremos cómo se están integrando los LLM en el proceso de pruebas de penetración. También analizaremos los límites estrictos de las pruebas de penetración basadas en GPT, desde las alucinaciones de la IA hasta las lagunas contextuales, y por qué la experiencia humana sigue siendo vital. Por último, veremos cómo el enfoque Aikido Security(nuestra plataforma de pruebas de penetración continua impulsada por IA) aborda estos retos de forma diferente con validación humana, resultados fáciles de usar para los desarrolladores e integración CI/CD. Profundicemos con una mirada tranquila y pragmática a esta nueva era de pruebas de penetración asistidas por IA.

¿Qué significa realmente (y qué no significa) «Pentest GPT»?

«Pentest GPT» se refiere a la aplicación de modelos de lenguaje de estilo GPT a los flujos de trabajo de pruebas de penetración. En términos sencillos, se trata de utilizar un cerebro de IA para emular partes del trabajo de un pentester, desde trazar rutas de ataque hasta interpretar los resultados de los escaneos. Sin embargo, no es tan sencillo como coger ChatGPT, ponerse una sudadera de hacker y esperar una prueba de penetración completa con una sola orden. La distinción es importante.

Los modelos generales como ChatGPT se entrenan con textos generales de Internet y, sin duda, pueden explicar conceptos de seguridad o generar ideas sobre ataques, pero carecen de conocimientos especializados en seguridad ofensiva por defecto. No se han creado con un conocimiento profundo de los marcos de explotación, las bases de datos CVE o el flujo de trabajo paso a paso que sigue un pentester real. Por el contrario, un verdadero sistema Pentest GPT suele estar optimizado para la seguridad. Está entrenado con datos seleccionados, como informes de vulnerabilidades, manuales de equipos rojos, código de explotación e informes reales de pruebas de penetración. Esta especialización significa que «habla» el lenguaje de las herramientas y técnicas de hacking.

Otra diferencia clave es la integración. Pentest GPT no es solo un chatbot aislado, sino que suele estar conectado a herramientas de seguridad y fuentes de datos reales. Por ejemplo, un Pentest GPT bien diseñado puede conectarse a escáneres y marcos (Nmap, Burp Suite, Metasploit, etc.) para poder interpretar sus resultados y recomendar los siguientes pasos. Actúa como una capa inteligente entre las herramientas, sin sustituirlas por completo. Una analogía útil de un comentario: ChatGPT puede ofrecerte un buen resumen de lo que es una inyección SQL, mientras que Pentest GPT puede guiarte para encontrar una inyección SQL activa en un sitio, generar una carga útil personalizada, validar el exploit e incluso sugerir una solución posterior. En resumen, Pentest GPT es más que «ChatGPT + un prompt = pentest». Implica un asistente de IA diseñado específicamente que comprende el contexto del hacking y puede actuar en consecuencia.

También vale la pena señalar lo que Pentest GPT no es. No es un hacker mágico de un solo clic que deja obsoletas todas las demás herramientas. En realidad, sigue dependiendo del arsenal habitual (escáneres, scripts y exploits), pero utiliza el LLM para unir todo. Piensa en él como un amplificador de la automatización: añade razonamiento y contexto a los resultados brutos que producen las herramientas automatizadas tradicionales. Y a pesar de su nombre pegadizo, «PentestGPT» en la práctica no es un único producto o modelo de IA, sino una categoría creciente de enfoques. Los primeros prototipos como PentestGPT (un proyecto de investigación de código abierto) y AutoPentest-GPT han demostrado pruebas de varios pasos guiadas por GPT-4, y las plataformas de seguridad establecidas (como Aikido) ahora están incorporando el razonamiento impulsado por GPT en sus motores de pruebas de penetración. El campo está evolucionando rápidamente, pero la idea central sigue siendo la misma: utilizar los LLM para que pentesting automatizado sean pentesting automatizado y más similares al pensamiento humano.

Cómo se utilizan los LLM (como GPT-4) en las pruebas de penetración

Las pruebas de penetración modernas implican mucho más que ejecutar un escáner y generar un informe. Los evaluadores expertos encadenan múltiples pasos, desde el reconocimiento hasta la explotación y la postexplotación, a menudo improvisando en función de lo que encuentran. Los LLM están demostrando ser muy útiles para ayudar (o incluso realizar de forma autónoma) varias de estas fases. Estas son algunas de las funciones clave que desempeña la IA basada en GPT en el proceso de pruebas de penetración:

1. Razonamiento de ruta: conectando los puntos entre vulnerabilidades

Una de las capacidades más potentes de una IA como GPT-4 es planificar ataques en varios pasos, casi como un estratega humano. Por ejemplo, un escáner de vulnerabilidades típico podría indicarle que «el servidor X está ejecutando un servicio obsoleto» y, por separado, que «la base de datos de usuarios tiene credenciales predeterminadas débiles». Depende de un pentester humano darse cuenta de que estos dos hallazgos podrían combinarse: iniciar sesión en la base de datos con las credenciales predeterminadas y pivotar para explotar el servidor obsoleto y obtener un acceso más profundo. Los LLM destacan en este tipo de razonamiento. Un Pentest GPT puede conectar automáticamente los puntos en una ruta de ataque, identificando que una cadena de problemas de menor gravedad, cuando se utilizan juntos, podrían conducir a un compromiso importante (por ejemplo, derechos de administrador de dominio o toma de control total de la aplicación). Esta síntesis del «panorama general» es algo que las herramientas basadas en reglas rara vez hacen, pero un modelo GPT puede hacerlo, gracias a su comprensión contextual. En la práctica, esto significa que las herramientas de pruebas de penetración impulsadas por la IA pueden proporcionar narrativas de ataque, no solo hallazgos aislados. Explican cómo una pequeña configuración incorrecta más una clave API filtrada podrían escalarse a una brecha crítica, lo que proporciona a los desarrolladores y a los equipos de seguridad una visión mucho más clara de los riesgos.

2. simulación de ataques: Creación y ejecución de exploits

Los LLM como GPT-4 también se utilizan para simular las acciones de los atacantes durante una prueba de penetración. Esto va más allá de simplemente señalar una vulnerabilidad: la IA puede ayudar a ejecutar los pasos de explotación (de forma controlada). Por ejemplo, si el sistema sospecha de una inyección SQL en un formulario web, un agente de IA puede generar una carga útil personalizada para ese formulario específico e intentar recuperar datos. Si encuentra una inyección de comandos, puede intentar generar un shell o extraer información confidencial, tal y como lo haría un humano. El modelo puede basarse en su entrenamiento (que incluye miles de ejemplos de explotación) para crear cadenas de entrada o solicitudes HTTP sobre la marcha. Esta capacidad de adaptarse y crear cargas útiles de ataque ahorra mucho trabajo de programación manual. Básicamente, permite a la IA actuar como desarrollador y operador de exploits. Igualmente importante es que un buen Pentest GPT validará el efecto del exploit, por ejemplo, confirmando que el SQLi realmente ha volcado la base de datos o que la inyección de comandos permite la ejecución remota de código, en lugar de confiar ciegamente en su primer intento. En la plataforma de Aikido, por ejemplo, una vez que un agente descubre un problema potencial, ejecuta automáticamente comprobaciones y cargas útiles adicionales para demostrar que el hallazgo es explotable, lo que garantiza que el resultado no sea una falsa alarma. Este tipo de simulación de ataques impulsada por IA acerca mucho más las pruebas automatizadas a lo que haría un atacante humano creativo: probar algo, ver la respuesta, ajustar las tácticas y pasar al siguiente paso.

3. Pasos encadenados: ataques adaptativos en varias etapas

Las pruebas de penetración rara vez son un proceso de un solo paso, sino una cadena de acciones y reacciones. Los LLM se utilizan para orquestar cadenas de ataques de varias etapas de forma adaptativa. Consideremos un escenario: un agente de IA comienza con el reconocimiento, encuentra algunos puertos abiertos y una credencial filtrada, y luego utiliza la lógica impulsada por GPT para decidir el siguiente paso, tal vez utilizar la credencial para iniciar sesión, luego ejecutar un exploit de escalada de privilegios en el sistema de destino, y así sucesivamente. A diferencia de las herramientas tradicionales que siguen un guion fijo, un sistema guiado por LLM puede tomar decisiones sobre la marcha. Si una vía se bloquea (por ejemplo, si falla el inicio de sesión o un servicio no es explotable), puede cambiar dinámicamente de rumbo e intentar una ruta diferente, tal y como haría un humano. Los investigadores describen esto como un enfoque «agénico »: múltiples agentes de IA se encargan de diferentes tareas (reconocimiento, análisis de vulnerabilidades, explotación, etc.) y se pasan información entre sí, coordinados por el razonamiento del LLM. El resultado es una prueba de penetración automatizada que mantiene el contexto en todos los pasos y aprende sobre la marcha. Por ejemplo, los hallazgos en las primeras etapas (como una lista de roles de usuario o un esquema de API) pueden servir de base para ataques posteriores (como probar el control de acceso basado en roles). El razonamiento en lenguaje natural de GPT-4 ayuda en este sentido, ya que interpreta datos no estructurados (documentos, mensajes de error) e incorpora ese conocimiento en exploits posteriores. Esta capacidad de encadenamiento era tradicionalmente un dominio exclusivo de los humanos. Ahora, los agentes de IA pueden manejar muchas de estas transiciones lógicas: reconocimiento → explotación → postexplotación → limpieza, encadenando múltiples técnicas para lograr un objetivo. Por supuesto, no es infalible: la lógica empresarial compleja o las nuevas vías de ataque aún pueden hacer tropezar a una IA, pero supone un gran avance en cuanto a capacidad. Cabe destacar que así es como funciona la prueba de penetración de IA de Aikido: decenas o cientos de agentes invaden el objetivo en paralelo, cada uno centrándose en diferentes ángulos, y el sistema utiliza un cerebro impulsado por LLM para coordinar su progreso a través de una cadena de ataque (descubrimiento, explotación, escalada de privilegios, etc.). El resultado es un ejercicio mucho más exhaustivo en el que la IA puede escalar los hallazgos paso a paso, en lugar de detenerse en una lista interminable de problemas separados.

Límites de las pruebas de penetración basadas en GPT: alucinaciones, lagunas contextuales y el factor humano

Con todo el entusiasmo que rodea a pentesting de IA, es importante abordar sus limitaciones y por qué los humanos aún no han quedado fuera de juego. Los LLM son potentes, pero tienen debilidades bien documentadas que son importantes en el contexto de la seguridad. A continuación se presentan algunas limitaciones clave de las pruebas de penetración «impulsadas por GPT» y por qué los expertos humanos con experiencia siguen desempeñando un papel crucial:

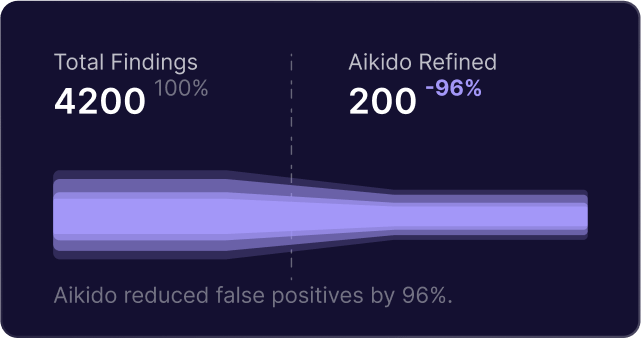

- Alucinaciones y falsos positivos: los modelos GPT a veces producen información que parece plausible pero que es incorrecta, un fenómeno conocido como alucinación. En las pruebas de penetración, esto podría significar que una IA marque incorrectamente una vulnerabilidad que en realidad no existe o malinterprete un comportamiento benigno como malicioso. Por ejemplo, un GPT podría inventar un «CVE-2025-9999» ficticio basándose en los patrones que ha visto, o concluir erróneamente que un sistema es vulnerable porque espera una respuesta determinada. Estos falsos positivos pueden hacer perder tiempo y minar la confianza en la herramienta. Para contrarrestar esto, es necesaria una validación rigurosa. (En el sistema de Aikido, por ejemplo, no se informa de ningún hallazgo hasta que se valida mediante un exploit o una comprobación reales; la plataforma vuelve a ejecutar el ataque o la carga útil de prueba automáticamente para asegurarse de que el problema es reproducible). Este tipo de salvaguardia es esencial porque, de lo contrario, un LLM, si no se controla, podría convencerse a sí mismo de encontrar fantasmas.

- Falta de contexto profundo o conocimientos actualizados: los conocimientos de un LLM están limitados por sus datos de entrenamiento. Si el modelo no se ha actualizado recientemente, es posible que no detecte vulnerabilidades o técnicas recientemente reveladas; por ejemplo, un exploit publicado el mes pasado no será conocido por un modelo entrenado el año pasado. Además, los GPT no conocen de forma inherente el contexto específico de su aplicación. No tienen la intuición ni la familiaridad que un probador humano podría desarrollar después de explorar manualmente una aplicación durante días. Si no se le proporciona suficiente contexto (como el código fuente, la documentación o las credenciales de autenticación), un agente de IA podría pasar por alto sutiles fallos lógicos o malinterpretar la importancia de ciertos hallazgos. Básicamente, los GPT tienen amplios conocimientos sobre seguridad, pero no un profundo conocimiento innato de su entorno. Proporcionar a la IA más contexto (como conectar el código del repositorio o las descripciones del flujo de usuarios) puede mitigar esto, pero sigue habiendo una diferencia entre conocer mucha información general y comprender realmente un sistema objetivo personalizado. Esta es una de las razones por las que el juicio humano sigue siendo crucial: un probador experto puede detectar anomalías o problemas de lógica empresarial de alto nivel que una IA que no esté adaptada al negocio podría no comprender. (Dicho esto, curiosamente, cuando se le proporciona código y contexto a la IA de Aikido, esta ha descubierto incluso vulnerabilidades lógicas complejas, como eludir flujos de trabajo de varios pasos, que los evaluadores humanos pasaron por alto. El contexto es fundamental tanto para la IA como para los humanos).

- Dependencia excesiva de los patrones: Las IA tradicionales de pruebas de penetración pueden basarse en patrones de ataque y manuales conocidos. Si algo se sale de esos patrones, la IA podría tener dificultades. Por ejemplo, un mecanismo de seguridad novedoso o una implementación criptográfica inusual podrían confundir al modelo, mientras que un humano podría investigarlo de forma creativa. GPT-4 sin duda puede generalizar e incluso ser creativo, pero al final sigue los patrones estadísticos de su entrenamiento. Esto significa que le resulta más difícil encontrar vulnerabilidades en casos extremos o fallos muy específicos de una aplicación (por ejemplo, el abuso de una función de la aplicación de una forma que nadie ha descrito públicamente). Los seres humanos, con su intuición y su capacidad para manejar la ambigüedad, siguen destacando a la hora de descubrir esos problemas extraños y puntuales.

- Restricciones éticas y de alcance: una consideración práctica: los modelos GPT no conocen de forma inherente los límites éticos o las restricciones de alcance de una prueba de penetración, a menos que se controlen explícitamente. Un pentester humano es consciente de que no debe interrumpir la producción, evitar la destrucción de datos, etc. Un agente autónomo puede necesitar barreras de protección estrictas (y, de hecho, las buenas plataformas proporcionan configuraciones de modo seguro y definiciones de alcance para mantener a los agentes de IA centrados en el objetivo y no destructivos). Aunque se trata más de un problema de diseño de la plataforma que de un defecto del GPT en sí, subraya que se necesita la supervisión humana para garantizar que la IA funcione de forma segura y dentro de las reglas de compromiso acordadas.

- La necesidad de interpretación y orientación humanas: Por último, incluso cuando la IA hace todo correctamente, a menudo se necesita a un humano para interpretar los resultados y tomar decisiones estratégicas. Por ejemplo, decidir qué vulnerabilidades son realmente importantes para la empresa o pensar en cómo un atacante podría explotar un hallazgo más allá de lo que se ha hecho automáticamente puede requerir el toque humano. También está el aspecto de la confianza: muchas organizaciones quieren que un human security revise un informe de pruebas de penetración generado por IA, tanto para verificarlo como para traducirlo a términos empresariales cuando sea necesario. La IA puede generar una gran cantidad de datos; se necesita la experiencia humana para priorizar y planificar las medidas correctivas en un contexto más amplio de programas de seguridad.

En resumen, las pruebas de penetración basadas en GPT son un multiplicador de fuerzas más que un sustituto de los seres humanos. Pueden encargarse de la pesada tarea de los ataques rutinarios, abarcar más terreno y hacerlo de forma continua. Pero los seres humanos siguen fijando los objetivos, gestionando los casos novedosos y proporcionando un juicio crítico sobre el riesgo. Como se ha señalado en una observación, los mejores resultados se obtienen cuando el GPT se combina con herramientas deterministas y la supervisión humana: la IA se encarga del razonamiento y la elaboración de informes, mientras que las herramientas y las personas garantizan una validación fiable. La mayoría de los equipos que adoptan pentesting de IA las pentesting de IA como base y luego añaden la revisión humana para el tramo final. De este modo, se obtiene la eficiencia de la IA y la sabiduría de los expertos humanos trabajando en tándem.

El enfoque de Aikido: pentesting de IA continuas pentesting de IA un toque humano.

En Aikido Security, hemos adoptado la IA en el pentesting a través de nuestra plataforma (denominada Aikido “Attack”), pero lo hemos hecho prestando especial atención a los límites mencionados. El objetivo es aprovechar los LLM por lo que mejor saben hacer –velocidad, escala y razonamiento– mientras se mitigan sus debilidades. Así es como los pentests impulsados por IA de Aikido difieren de un script básico de “Pentest GPT” o de las herramientas automatizadas tradicionales:

- Pruebas continuas y bajo demanda (integración CI/CD): Aikido le permite ejecutar pruebas de penetración siempre que lo necesite, incluso con cada cambio de código. En lugar de un pentest anual de gran impacto, puede integrar las pruebas de seguridad impulsadas por IA en su pipeline de CI/CD o en sus despliegues de staging. Esto significa que las nuevas características o correcciones se prueban inmediatamente, y la seguridad se convierte en un proceso continuo en lugar de un evento puntual. Nuestra plataforma está diseñada para los flujos de trabajo de los desarrolladores, por lo que puede activar un pentest en una pull request o programar ejecuciones nocturnas. Para cuando su aplicación entra en producción, ya ha pasado por un guante de pruebas impulsadas por IA. Este enfoque continuo aborda la brecha de velocidad donde el código cambia a menudo diariamente, pero los pentests manuales ocurren raramente. Con los agentes de IA, las pruebas se mantienen al día con el desarrollo.

- Resultados validados y sin ruido: Reconocemos que la salida de una IA necesita verificación. El motor de pentest de Aikido tiene validación integrada en cada paso. Cuando la IA sospecha una vulnerabilidad, no la reporta inmediatamente, sino que lanza un agente de validación secundario para reproducir el exploit de forma limpia y confirmar el impacto. Solo los problemas probados y explotables llegan al informe final. Este diseño significa que obtiene prácticamente cero falsos positivos (si un problema no se confirma, no se reporta) y nuestro sistema se protege activamente contra las alucinaciones de IA sobre vulnerabilidades. El resultado es que los desarrolladores no son bombardeados con alertas de “posibles problemas” o hallazgos especulativos; ven agujeros de seguridad reales y confirmados con pruebas. Este enfoque une la creatividad de GPT con la cautela de un probador humano: cada hallazgo se verifica esencialmente dos veces, por lo que puede confiar en el resultado.

- Visibilidad total y resultados amigables para desarrolladores: El pentest de IA de Aikido no funciona como una caja negra. Le ofrecemos visibilidad total de lo que hacen los agentes de IA – cada solicitud, carga útil e intento de ataque puede observarse en vivo en nuestro panel de control. Esto es crucial para la confianza y el aprendizaje del desarrollador. Puede ver por qué se marcó una vulnerabilidad y cómo se explotó, hasta las trazas de solicitud/respuesta e incluso capturas de pantalla del ataque en curso. Los resultados finales se presentan en un informe listo para auditoría que incluye todos los detalles técnicos (endpoints afectados, pasos de reproducción, marcas de tiempo), así como descripciones de riesgos en lenguaje sencillo y orientación para la remediación. Nuestro objetivo es que la salida sea amigable para el desarrollador: en lugar de una vaga “Vulnerabilidad en el módulo X”, obtiene una explicación clara del problema, cómo reproducirlo y cómo solucionarlo. Incluso vamos un paso más allá: nuestra plataforma incluye una función AutoFix que puede tomar ciertos hallazgos (como una inyección SQL o una inyección de comandos detectada) y generar automáticamente una pull request de Git con los cambios de código propuestos para solucionar el problema. Los desarrolladores pueden revisar esta corrección generada por IA, fusionarla y luego hacer que Aikido vuelva a probar la aplicación inmediatamente para verificar que la vulnerabilidad se ha resuelto. Este ciclo ajustado de encontrar→corregir→volver a probar significa una remediación más rápida y menos idas y venidas. Todo esto se hace de una manera que los desarrolladores pueden digerir fácilmente, evitando la jerga de seguridad o la interminable salida bruta del escáner. Se trata de hacer que los resultados del pentest sean accionables.

- Experiencia humana en el ciclo: Aunque nuestros agentes de pentesting operan de forma autónoma, no hemos eliminado el elemento humano, sino que lo hemos aumentado. En primer lugar, el propio sistema fue entrenado y ajustado con la aportación de probadores de penetración sénior, codificando sus flujos de trabajo y conocimientos. Pero más allá de eso, fomentamos y apoyamos la validación humana donde importa. Muchos clientes de Aikido utilizan los hallazgos de la IA como base y luego hacen que su equipo de seguridad o un analista de Aikido realice una revisión rápida, especialmente para aplicaciones críticas. Nuestra experiencia ha demostrado que la IA detectará por sí misma la gran mayoría de los problemas técnicos (e incluso muchos fallos lógicos complejos). Sin embargo, sabemos que la seguridad se trata en última instancia de una defensa en profundidad, por lo que una verificación humana puede añadir seguridad, y facilitamos la colaboración en torno a los resultados de la IA. Además, si la ejecución de la IA no encuentra nada crítico (lo cual es una gran noticia), las organizaciones tienen la tranquilidad de nuestra política de que “Cero Hallazgos = Cero Coste” para ciertos compromisos. Esta garantía refleja nuestra confianza en la exhaustividad de la IA, pero también asegura que si un humano encuentra más tarde algo que la IA pasó por alto, no habrá pagado por una prueba incompleta. En resumen, el enfoque de Aikido combina la automatización de la IA con opciones de supervisión humana para ofrecer lo mejor de ambos mundos.

- Seguridad y control de alcance: Aikido Attack fue construido pensando en las necesidades empresariales, por lo que añadimos controles robustos para mantener la IA en el camino correcto. Antes de que se ejecute un pentest de IA, usted define el alcance exacto: qué dominios o IPs son objetivos permitidos, cuáles están fuera de los límites (pero pueden ser accedidos en modo de solo lectura), detalles de autenticación e incluso ventanas de tiempo para las pruebas. La plataforma los aplica con un proxy integrado y comprobaciones “pre-vuelo”: si algo está mal configurado o fuera de alcance, la prueba no continuará, evitando accidentes. También hay un “botón de pánico” instantáneo para detener las pruebas inmediatamente si es necesario. Estas medidas aseguran que una prueba autónoma nunca se descontrole y solo realice acciones seguras y acordadas, al igual que lo haría un pentester humano diligente. Para más información sobre cómo protegemos su entorno, consulte la arquitectura de seguridad de Aikido.

En general, la solución de pentest impulsada por IA de Aikido cumple la promesa de Pentest GPT al tiempo que resuelve sus inconvenientes. Obtiene pentesting continuo e inteligente que puede pivotar y razonar a través de ataques como un humano, sin la espera o el coste típicos de las pruebas manuales. Al mismo tiempo, no obtiene el ruido habitual de la automatización: cada hallazgo es real y viene con contexto. Y todavía tiene la opción (y la fomentamos) de involucrar a ingenieros de seguridad para la validación final o para manejar los casos extremos, asegurando que nada se escape. Es una aplicación equilibrada y pragmática de la IA: usar la máquina para lo que mejor sabe hacer (velocidad, escala, reconocimiento de patrones) y dejar que los humanos hagan lo que mejor saben hacer (pensamiento creativo y juicio de la situación general). El resultado final es un proceso de pentest que es más rápido y frecuente, pero también exhaustivo y fiable.

Del bombo a la realidad: pruebe usted mismo el pentesting impulsado por IA

Explore los recursos y herramientas externos a los que se hace referencia en este enfoque:

- Nmap – Mapeador de red de código abierto utilizado para el reconocimiento.

- Burp Suite – Escáner de vulnerabilidades web y proxy utilizado en muchos pentests impulsados por IA.

- Metasploit – Framework de pruebas de penetración para el desarrollo y ejecución de exploits.

- Base de datos CVE (NVD) – La Base de Datos Nacional de Vulnerabilidades para el seguimiento de fallos de seguridad.

- PentestGPT GitHub – Proyecto de investigación de Pentest GPT de código abierto.

- Proyecto AutoPentest-GPT – Framework de pentesting automatizado construido sobre tecnología GPT.

Para ver cómo puede llevar el pentesting continuo e inteligente a su organización, empiece con Aikido en 5 minutos o lea historias de éxito de clientes sobre organizaciones que ya están reduciendo riesgos con IA.

Para más contenido educativo sobre desarrollo seguro, DevSecOps y IA en seguridad, explore el Blog de Aikido.

La IA no reemplazará a los expertos en seguridad humanos, pero sí hará su trabajo más eficiente y ayudará a las organizaciones a proteger el software a un ritmo que coincida con el desarrollo moderno. Los LLM están demostrando que pueden encargarse de gran parte del trabajo pesado de las pruebas de penetración, desde la búsqueda de debilidades en una aplicación hasta la escritura de exploits y la compilación de informes. Como hemos comentado, el término Pentest GPT significa esta nueva generación de herramientas que fusionan el razonamiento de la IA con el conocimiento de hacking. No es solo bombo; ya está remodelando cómo se realizan los pentests, convirtiendo una tarea anual en una práctica continua y amigable para el desarrollador.

Si tiene curiosidad por ver esto en acción, ¿por qué no prueba el Pentest de IA de Aikido? Ofrecemos una forma de ejecutar un pentest gratuito y de autoservicio en su propia aplicación para experimentar cómo los agentes autónomos trabajan junto a su ciclo de desarrollo. En cuestión de minutos, puede configurar una prueba y observar cómo los agentes de IA sondean sistemáticamente su aplicación, con total transparencia y control. Obtendrá un informe detallado en horas (no en semanas), e incluso puede integrarlo en su pipeline de CI para que cada nueva versión se pruebe automáticamente. Es una oportunidad para presenciar cómo los conceptos de Pentest GPT –razonamiento de rutas, explotación inteligente, validación de resultados– se unen en un producto real.

Consejo profesional: Puede iniciar un pentest impulsado por IA en Aikido de forma gratuita (no se requiere tarjeta de crédito) o [obtenga más información en nuestro sitio web] sobre cómo funciona. Estamos seguros de que una vez que vea cómo la IA encuentra y corrige vulnerabilidades a la velocidad de una máquina, estará de acuerdo en que esta es una forma más tranquila e inteligente de mantener su software seguro.

En resumen, la IA ha llegado para quedarse en la ciberseguridad. La clave está en usarla sabiamente. Pentest GPT, como concepto, trata de aumentar la experiencia humana con las increíbles capacidades de la IA, no de reemplazar esa experiencia. La misión de Aikido es ofrecer pentests continuos impulsados por IA con validación humana integrada, para que pueda detectar problemas de forma temprana, frecuente y con confianza. A medida que la industria evoluciona, aquellos que combinen la eficiencia de la IA con el ingenio de la inteligencia humana estarán mejor posicionados para proteger sus sistemas contra el panorama de amenazas en constante cambio. El futuro del pentesting se está escribiendo ahora, y en parte lo está escribiendo GPT-4.

(¿Interesado en dar el siguiente paso? Puede empezar con un pentest de IA en 5 minutos en la plataforma de Aikido o programar una demostración para ver cómo se integra en su flujo de trabajo de DevSecOps. Las pruebas de seguridad no tienen por qué ser lentas o aisladas; con las herramientas de IA adecuadas, se convierten en una parte continua del desarrollo, lo que permite a su equipo construir y lanzar software con tranquilidad.)

Protege tu software ahora.